Interview mit Stefanie Valdés-Scott von Adobe

Stell Dir vor, Kim Kardashian würde ihre gephotoshopten Bilder auch als solche kennzeichnen. Und jeder schönende Filter, jede geglättete Falte, jeder Shape an ihrer Silhouette könnte via Klick offengelegt werden. Dafür haben Adobe und die Content Authenticity Initiative (CAI) nun die technischen Voraussetzungen geschaffen. Mit dem Tool Content Credentials. Wie kommt’s, Adobe? Was ist das übergeordnete Ziel? Und wie passt das mit Photoshop zusammen? Wir haben Stefanie Valdés-Scott, Head of Government Relations Central Europe @Adobe, interviewt. Ein Deep Talk über Deep Fakes, was Deep Fakes mit unserer Gesellschaft machen und wie eine Exit-Strategie aussehen könnte. Get inspired!

Stefanie, auf welchen Deep Fake bist Du zuletzt reingefallen?

Sollte ich auf einen reingefallen sein, dann habe ich es nicht gemerkt. Häufig sind Fakes ja technisch so gut gemacht, dass man sie mit bloßem Auge gar nicht erkennen kann.

So wie der Varoufakis-Fake 2015.

Ja, richtig! Solche Fakes können natürlich fatale Auswirkungen haben.

Warum fallen wir auf sie rein?

Weil wir dazu neigen, zu glauben, dass Bilder, Videos und Audios genau das einfangen, was auch wir mit unseren eigenen Augen sehen oder unseren eigenen Ohren hören würden. Als wären sie eine Erweiterung unserer eigenen Wahrnehmung. Deep Fakes sind vollständig von künstlicher Intelligenz (KI) generierte oder mithilfe von KI teilweise manipulierte synthetische Medien. Sie sollen absichtlich täuschen.

KI entwickelt sich rasant weiter und Deep Fakes nehmen zu. Was sind die Konsequenzen?

Oft werden Deep Fakes ganz bewusst als Desinformation verbreitet. Damit fördern sie gezielt den Vertrauensverlust in Fakten und in die Wahrheit. Die Konsequenzen sind vielschichtig: Wir können das, was wir sehen oder hören, nicht mehr automatisch mit Echtheit und Wahrheit gleichsetzen. Menschen glauben zum einen falschen Inhalten, was ja schon schlimm genug ist. Zum anderen aber schüren Deep Fakes die Skepsis: Selbst echten, authentischen Inhalten wird misstraut. Im Englischen nennt man das „Liar’s Dividend“.

Exakt das hat doch Trump genutzt: Er behauptete schlicht von wahren Inhalten, sie seien “Fakes” und Millionen von Menschen weltweit pflichten ihm bis heute bei. Gibt es aus Deiner Sicht bestimmte Gruppen, die anfälliger für Fehlinformationen und Deep Fakes sind als andere?

Ja, Menschen, die gar nicht wissen, dass es solche Tools gibt. Dass sich über KI gezielt gefälschte Medieninhalte gestalten lassen. Aus meiner Sicht sind unbedingt mehr Medienkompetenz und Verbraucheraufklärung rund um das Thema Deep Fakes erforderlich. So könnte die Verbreitung von Desinformationen in der gesamten Gesellschaft zumindest eingedämmt werden.

Gibt es Branchen, die härter von Deep Fakes getroffen werden?

Unter anderem die Medienbranche. Zuletzt hatten wir eine „Infodemie“ – eine Flut an Fehl- und Falschinformationen – zur Corona-Pandemie beobachtet. Es kursieren auch immer noch viele Fehlinformationen rund ums Virus und die Impfstoffe. Deep Fakes sind aber über Branchen hinweg ein zunehmendes Problem. Sie schaden Verbraucher*innen und Urheber*innen gleichermaßen. Sie sind einfach ein gesamtgesellschaftliches Problem.

Stefanie Valdés-Scott ist Head of Government Relations Central Europe bei Adobe. Foto: © Laurence Chaperon

Täuscht der Eindruck oder sind Frauen öfter Opfer von Deep Fakes?

Leider nicht. Es ist sehr gut dokumentiert, dass Frauen sogar überproportional von Deep Fakes betroffen sind. Denken wir an pornographische Deep Fakes, so sind oft weibliche Celebrities die Opfer. Oder bei Revenge Porns – Rachevideos, die in der Regel von Ex-Freunden oder Ex-Männern in Umlauf gebracht werden.

Böse Zungen könnten behaupten, Tools wie Photoshop hätten erst die Grundlage für Deep Fakes gelegt. Denken wir an die dargestellte Makellosigkeit und Perfektion in Werbung, Beauty- und Fashion-Industrie, dann sind sie doch im Grunde auch Deep Fakes. Oder? Besonders bei jungen Frauen sorgt das nachweislich für psychische Erkrankungen.

Bilder und Videos zu bearbeiten ist nicht per se etwas Schlechtes: Die große Mehrheit unserer Kund*innen nutzt unsere Tools für die Erstellung von modernster digitaler Kunst. Für Blockbuster-Filme und Medienkampagnen oder in wichtigen Bereichen wie Fotojournalismus. Millionen kreative Karrieren wurden weltweit durch Tools wie Photoshop ermöglicht. Das macht Freude! Und Adobe stolz. Aber: Die Kehrseite der Medaille ist, dass dieses Potenzial auch von „schlechten Akteuren“ missbräuchlich genutzt werden kann.

Die rasante Entwicklung rund um KI verbessert auch die eigenen Produkte.

Absolut. Dennoch sieht Adobe diese Entwicklungen auch sehr kritisch und findet: Es wäre falsch, sich hier untätig zurückzulehnen und zuzusehen, wie bewusst Schaden entsteht. Bei der Markteinführung neuer Technologien setzt Adobe sich für deren verantwortungsvolle Nutzung ein. Zum Wohle der Kreativen, unserer Kund*innen und der Gesellschaft als Ganzes. Um dem Phänomen entgegenzuwirken, hat Adobe 2019 die Content Authenticity Initiative (CAI) gegründet. Und vor wenigen Wochen das Tool Content Credentials in Photoshop gelauncht.

Worum geht es der Initiative?

Darum, das Vertrauen der Gesellschaft in Medien zu stärken bzw. es wiederherzustellen. Gestartet ist die Initiative CAI zu dritt: Adobe, Twitter und die New York Times Company. Heute zählt die Initiative über 400 Mitglieder, darunter Tech- und Medienunternehmen, NGOs, Think Tanks und Wissenschaft. Ebenso wie einzelne Akteure, Journalist*innen, Künstler*innen und andere Urheber*innen. Das gemeinsame Ziel ist, einen offenen Industriestandard zu schaffen.

Wie soll das gelingen?

Mithilfe von robusten, manipulationssicheren Herkunftsdaten. Die CAI-Technologie gibt Auskunft über die „digitale Provenienz“. Also, woher ein Inhalt stammt und wie er dann im weiteren Verlauf bearbeitet wurde. Das Tool soll Verbraucher*innen die Entscheidungsbefugnis zurückgeben, selbst zu beurteilen, welcher Inhalt authentisch ist.

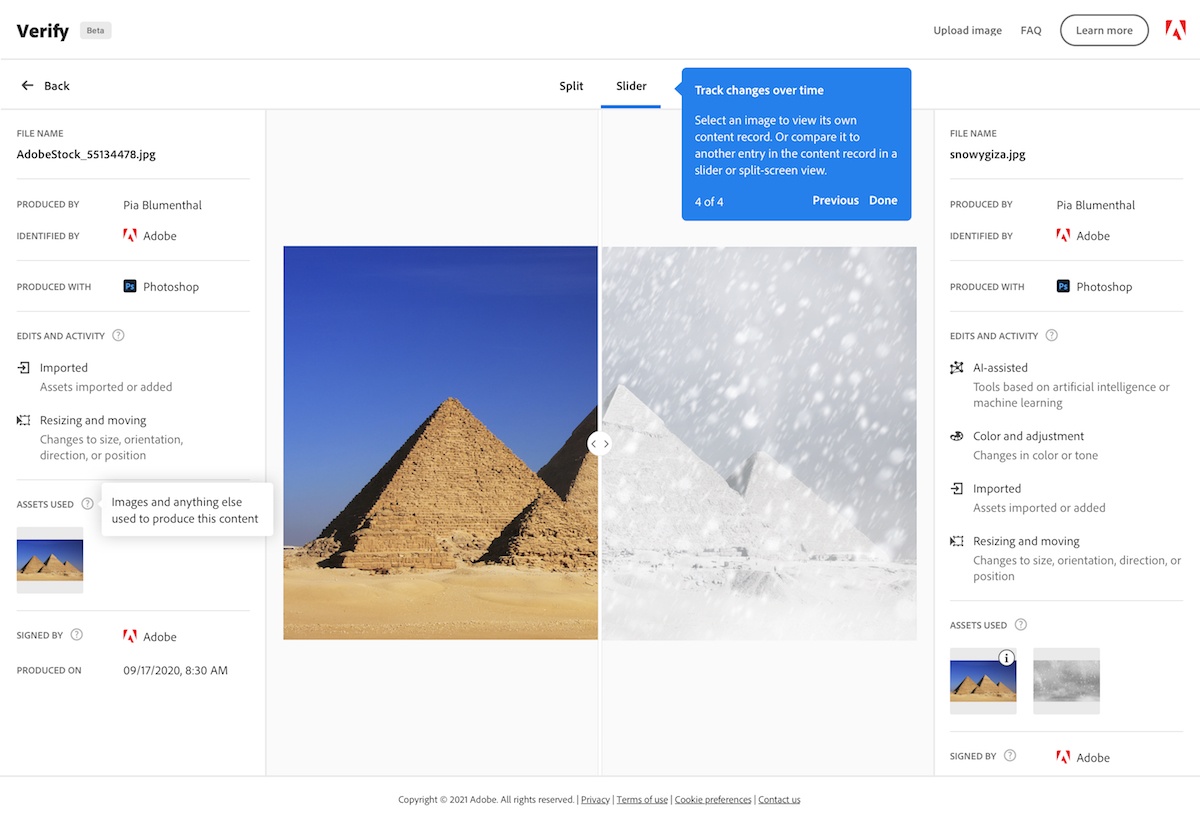

Wahrheit und Fake – auf einen Blick: Die Initiative CAI und das Tool Content Credentials von Adobe machen es möglich. Foto: Adobe

Was kann das Photoshop-Tool “Content Credentials”? Deckt es Deep Fakes auf?

Das war Adobe’s ursprüngliche Überlegung: ein Tool zu schaffen, das Fakes erkennt. Es wurde dann aber relativ schnell klar, dass das in einem Wettrüsten münden würde. Denn die KI-Systeme, die Fakes erkennen, lösen wiederum aus, dass die Systeme, die faken, immer besser werden. Daher die Entscheidung zur Umkehrung. Die Technologie soll nicht beweisen, was fake ist: Es soll den Akteur*innen, die wahre Inhalte bringen – beispielsweise Foto-/Journalist*innen – ein Authentifizierungs-Tool an die Hand geben.

Statt also zu versuchen, Fakes aufzudecken, liefert die CAI ein Echtheitszertifikat für wahre Inhalte. Was ist das Ziel, was die Vision dahinter?

Jeden Deep Fake aufzudecken, ist technisch gar nicht möglich. Die CAI-Technologie ist ein Opt-in, das von der Content-Erstellung über den Bearbeitungsverlauf bis hin zur Veröffentlichung eingesetzt werden kann. Ziel ist, dass die Herkunft von Content über das gesamte Informationsökosystem abgebildet wird. Die Vision ist, dass die CAI-Provenienz-Technologie zum Industriestandard wird. Dort, wo Inhalte nicht authentifiziert sind, sollte es zumindest für Skepsis bei den Konsument*innen sorgen. Klar ist es eine Frage, wer das Tool nutzt. Man kann schließlich niemanden dazu zwingen. Unsere Hoffnung ist aber, dass es sehr breit und von vielen Content Creators genutzt wird.

Nehmen wir an, das wäre der Fall:

Dann könnten Creator jede einzelne Retusche, die sie vornehmen, hinterlegen und abrufbar machen. Bleiben wir bei dem Beispiel Werbung, Fashion & Beauty: Werden Beauty Edits an Fotos gemacht – Pickel wegretuschiert, Falten, Polster, Cellulite etc. – dann können Konsument*innen sie via Klick aufs Info-Button einsehen. Noch besser funktioniert das über die Website Verify: Hier können retuschierte Bilder, bei denen die CAI-Technologie aktiviert wurde, hochgeladen und über einen visuellen Schieber mit dem Originalbild verglichen werden.

Welchen Effekt es wohl hätte, würde sich Kim Kardashian fortan zu Content Credentials committen…

Das wär’s! Wenn auch Celebrities und Influencer*innen die Filter und einzelnen Retuschen offenlegen würden, die sie nutzen! Damit würden sie ihr Personal Branding massiv prägen und den jungen Generationen Role Models für mehr Selbstbewusstsein und Authentizität sein.

Was wünscht Du Dir in diesem Zusammenhang für die Zukunft?

Dass die Medienkompetenz gestärkt wird, die Provenienztechnologie vorangetrieben wird und Erkennungstools im Kampf gegen Deep Fakes verbessert werden. Ich finde es wichtig und wünschenswert, dass sich alle Player aus dem Ökosystem ihrer Verantwortung bewusst werden und für authentische Inhalte in ihrem Bereich stark machen. Auch, dass sich die Politik diesem Bereich stärker annimmt. Es gehören nun mal alle dazu – Medien, Journalist*innen, Politik, Wissenschaft, Social Media-Plattformen und viele weitere mehr. Zuletzt auch wir Verbraucher*innen: Damit wir mit Deep Fakes umgehen können, müssen wir offen sein, dazuzulernen. Wie sonst wollen wir bewerten, welche digitalen Inhalte echt sind und welche nicht?